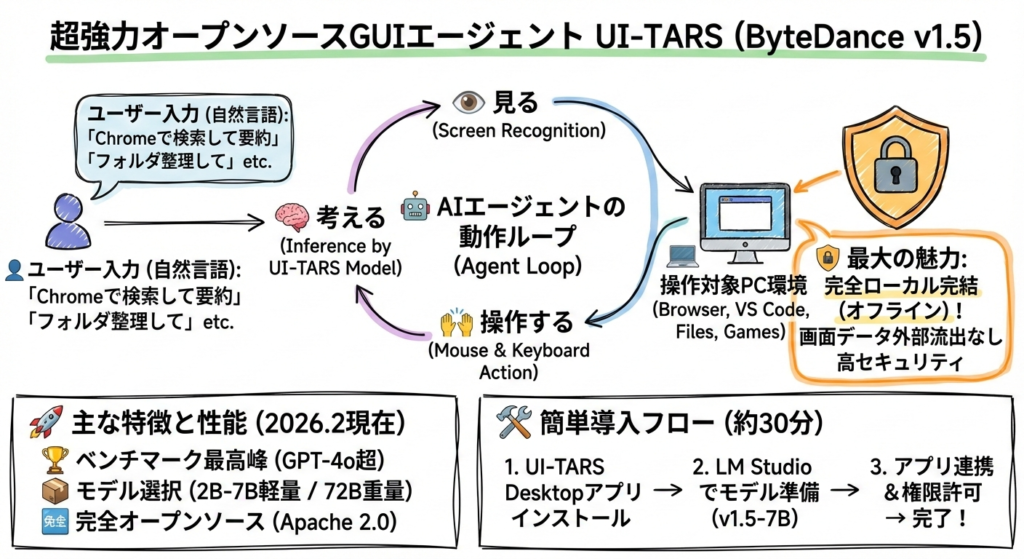

ByteDanceが開発したUI-TARS(特にUI-TARS-1.5シリーズ)は、2025〜2026年にかけて話題になった超強力なオープンソースのGUIエージェントです。

簡単に言うと、「自然言語でPCを操作してくれるAI」で、画面を見て考えてマウス・キーボードを動かしてくれます。ブラウザ操作、VS Codeでのコーディング補助、ファイル整理、簡単なゲーム自動プレイまで幅広く対応。しかも**ローカル完結(オフライン)**で動くので、画面データが外部に漏れにくいのが最大の魅力。

主な特徴(2026年2月現在)

- ベンチマークでトップクラス

OSWorld、AndroidWorld、ScreenSpotなどのGUI系ベンチマークで、GPT-4oやClaude 3.7/4を上回るスコアを記録(特に7Bモデルでこの性能は異常)。 - モデルサイズの選択肢

- 軽量:2B〜7B(RTX 3060〜4090で快適に動く)

- 重め:72B(ハイエンドGPU複数枚推奨)

- 完全オープンソース(Apache 2.0)

モデル weights、コード、データセットの多くが公開済み。 - 主な用途例

「Chrome開いてTwitterで最新のAIニュース検索してまとめて」

「このフォルダの画像を日付順にリネームして」

「VS Codeでこのリポジトリ開いてバグ修正提案して」など

中国オープンソース勢(DeepSeek、MiniMax、ByteDance)の「最強モデルを無料公開してエコシステム制覇」戦略の象徴的存在で、有料APIモデルへのカウンターとしてかなり効いています。簡単な導入方法(2026年2月時点の最も手軽なルート)一番のおすすめはUI-TARS Desktopアプリを使う方法です。ほぼインストールするだけで動きます。

- 公式GitHub Releasesからダウンロード

https://github.com/bytedance/UI-TARS-desktop/releases/latest

→ Windows / macOS / Linux 向けの最新インストーラーを落とす(.exe / .dmg / .AppImage など) - インストール

- Windows:exeを実行して次へ次へ

- macOS:dmgを開いてApplicationsにドラッグ

(初回起動時に「壊れている」と言われたらターミナルで以下を実行) bashxattr -cr /Applications/UI\ TARS.app - Linux:AppImageに実行権限つけてダブルクリック

- モデルを準備(一番簡単なのはLM StudioやOllama連携)

- おすすめ:LM Studio(Windows/macOS対応、初心者向け)

- LM Studioをインストール(https://lmstudio.ai/)

- 検索で「UI-TARS-1.5-7B」または「ByteDance-Seed/UI-TARS-1.5-7B」を探してダウンロード

(GGUF版が動かしやすい:mradermacherや他のquantized版でもOK) - UI-TARS Desktopを起動 → 設定 → Local Model → LM StudioのサーバーURL(通常 http://localhost:1234/v1)を入力

- または vLLM で本格ローカルサーバー(GPUある人向け) bash

pip install vllm python -m vllm.entrypoints.openai.api_server --model ByteDance-Seed/UI-TARS-1.5-7B→ UI-TARS Desktopで http://localhost:8000/v1 を指定

- おすすめ:LM Studio(Windows/macOS対応、初心者向け)

- 初回起動&テスト

アプリ起動 → 新規タスク作成 → 「自然言語で指示」を入力

例:「デスクトップのスクショ撮って、今日の日付のフォルダ作ってそこに保存して」 - 権限許可

初回は画面収録・アクセシビリティ・入力監視の許可を求められるので全部ONに(これがないと動かない)。

これで大体30分〜1時間以内に「画面を見ながら動くAIエージェント」がローカルで無料で使えます。

時間のある時に試します。