NotebookLMは情報漏洩しないという情報があります。

概ね正解ですが、知っておいた方が良いと思います。

業務で使う際、多くの方が気にするのは次の2点だと思います。

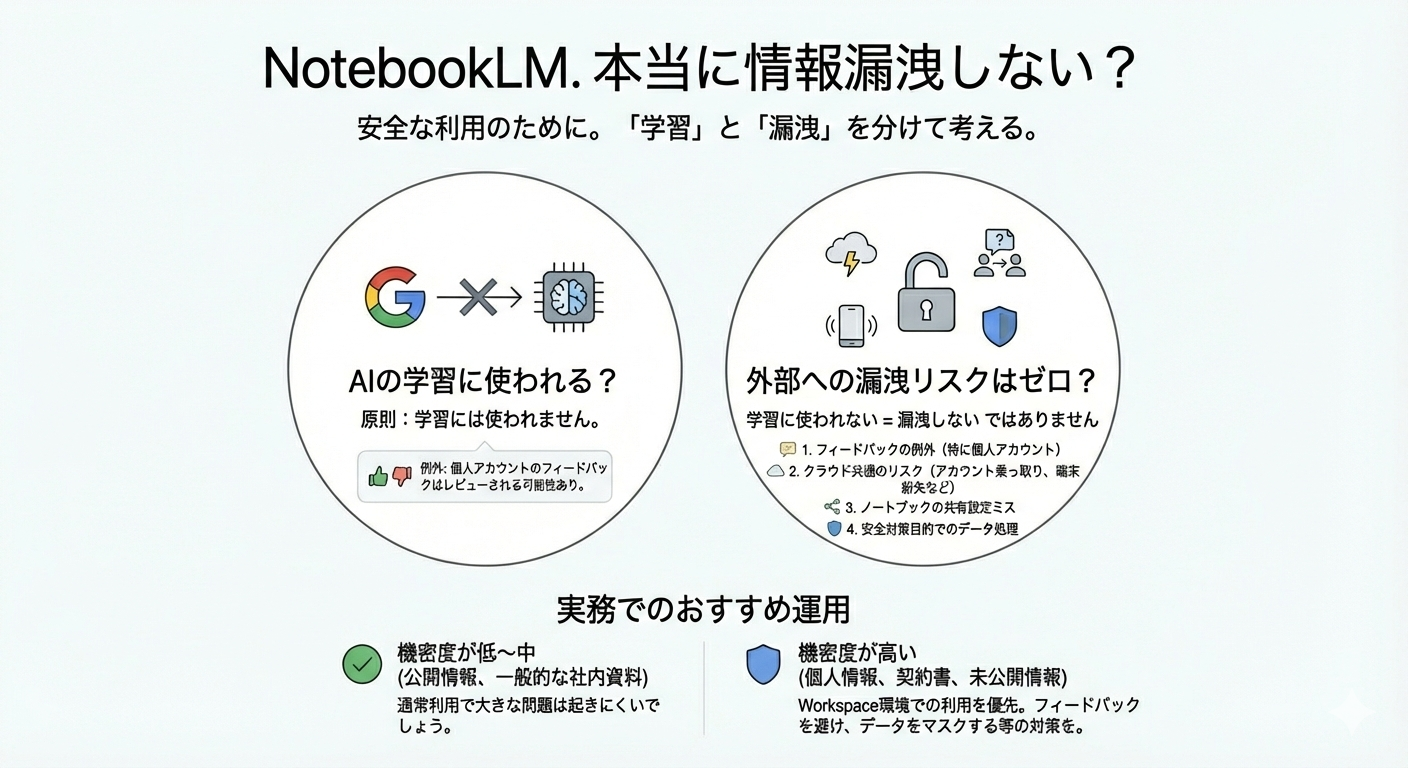

①入力した資料がAIの学習に使われるのか、

②外部に漏れるリスクをゼロと考えてよいのか

です。この2つは分けて考えると、理解しやすくなります。

学習に使われるのか?(結論)

まず結論から言うと、通常の利用において、NotebookLMにアップロードした資料やクエリ、生成結果は、原則としてAIモデルの学習には使われません。これはGoogleの公式ヘルプでも明記されています。

ただし例外があります。個人のGoogleアカウントでフィードバック(👍/👎など)を送信した場合、そのやり取りが人手でレビューされ、プロダクト改善の目的で参照される可能性があります。

一方、Google WorkspaceやEducationアカウントでは、アップロード内容やクエリ、出力は人手レビューも学習利用もされないと明確に説明されています。企業や学校向けに、より厳格なデータ保護が前提になっている点が特徴です。

では「漏えいの心配はない」のか?

ここで重要なのが、「学習に使われない=漏えいしない」ではないという点です。理由は主に次の4つです。

- フィードバック送信時の例外(特に個人アカウント)

- クラウドサービス共通のリスク(アカウント乗っ取り、端末紛失など)

- ノートブックの共有設定ミスによる情報拡散

- 不正利用防止など、安全対策目的でのデータ処理

これらはNotebookLM固有というより、クラウドサービス全般に共通する注意点と言えます。

実務でのおすすめ運用

実務では、情報の機密度で判断するのが現実的です。

- 機密度が低〜中(公開情報、一般的な社内資料)

→ 通常利用で大きな問題は起きにくいでしょう。 - 機密度が高い(個人情報、契約書、未公開の財務・技術情報)

→ Workspace環境での利用を優先し、個人アカウントではフィードバック送信を避ける、事前に情報をマスキングする、といった対策が安心です。

NotebookLMは便利なツールですが、「学習」と「漏えい」は別の軸で考えることが、賢い付き合い方と言えます。